Algorithme

Explications techniques

Dans cette section, les détails des filtres et de tamisage appliqué sur l'image seront expliqués.

Représentation de l'image.

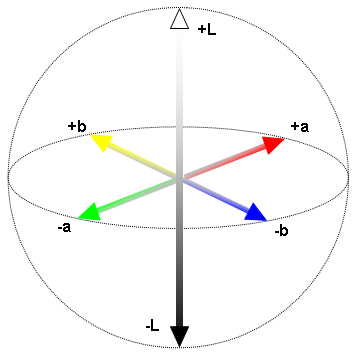

Contrairement à tous les projets faits dans ce cours, la représentation RGB n'a pas été utilisée. Pour ce travail, l'idée est de manipuler la luminance de chaque pixel et la meilleure représentation de celle-ci est donné dans l'espace de couleur CIE lab. Pour faire simple, chacun des pixels est alors représenté par un vecteur de 3 dimensions, L pour la luminance, A pour les chrominances de vert à rouge et B pour les chrominances de bleu à jaune. Les détails exacts pour la gestion de la chrominance m'échappent. Dans le contexte, ces détails ne sont vraiment pas pertinents. Nous n'utiliserons que la dimension de la (L)uminance. Voici une représentation plus imagée de l'espace de couleur CIE lab:

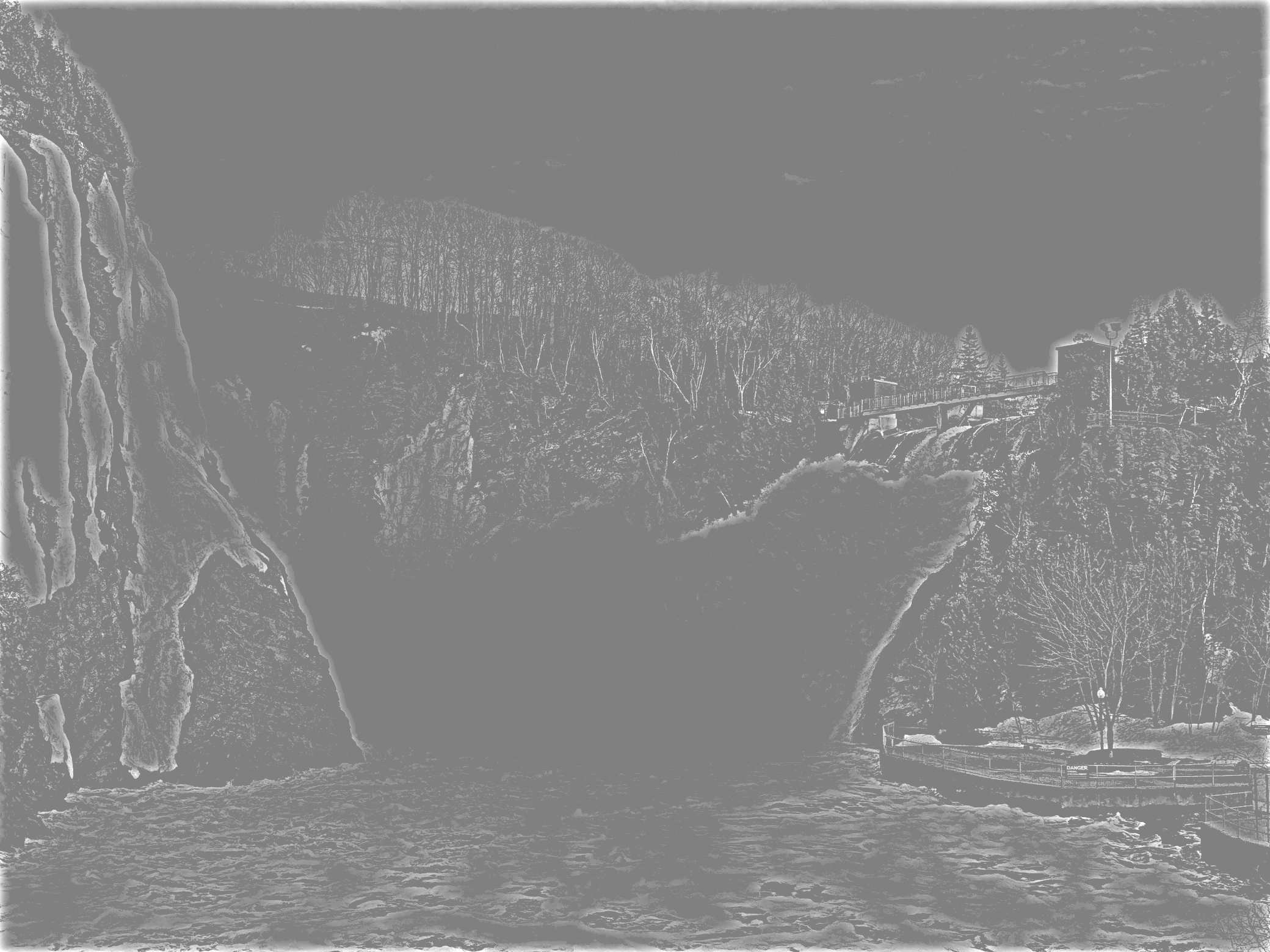

Filtre en fréquence

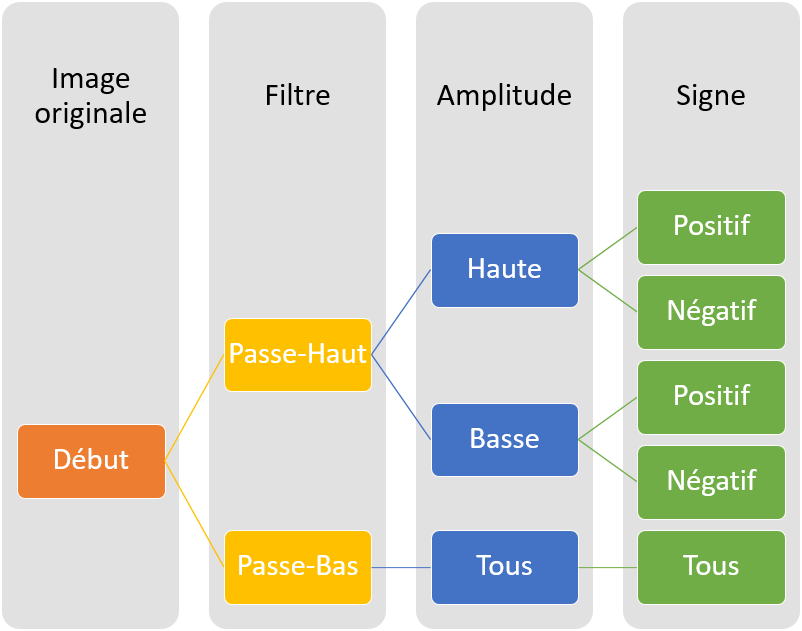

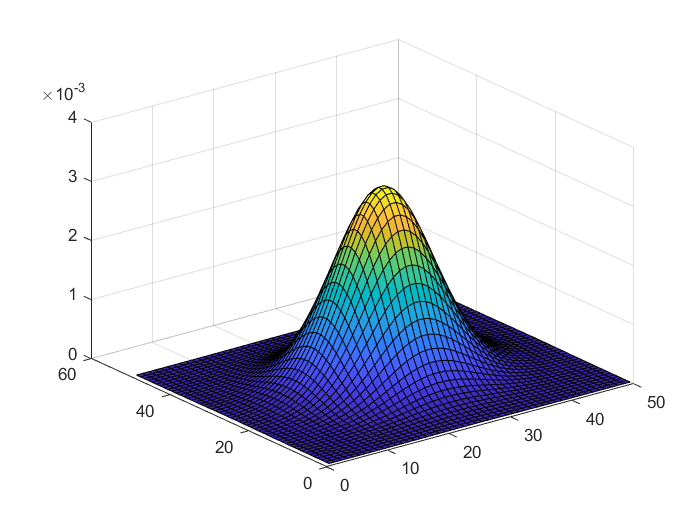

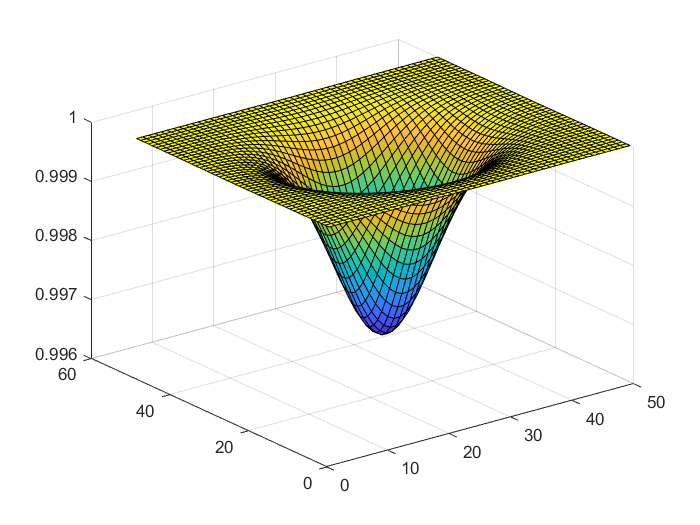

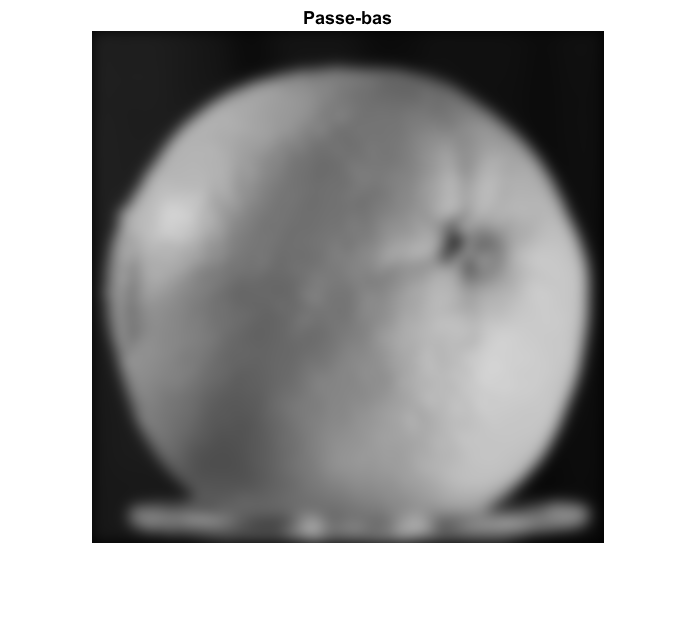

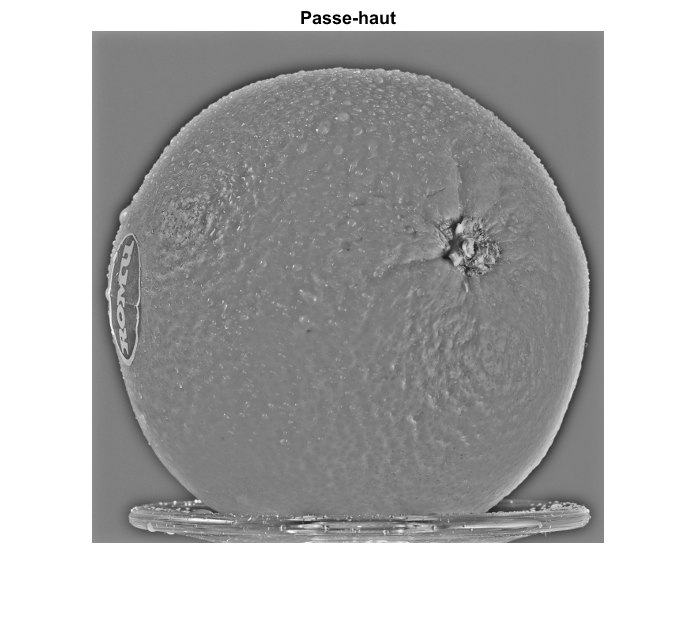

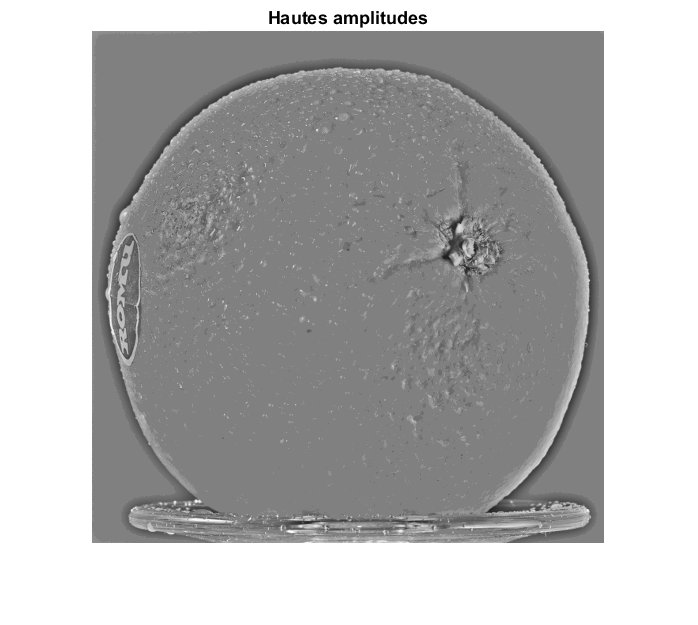

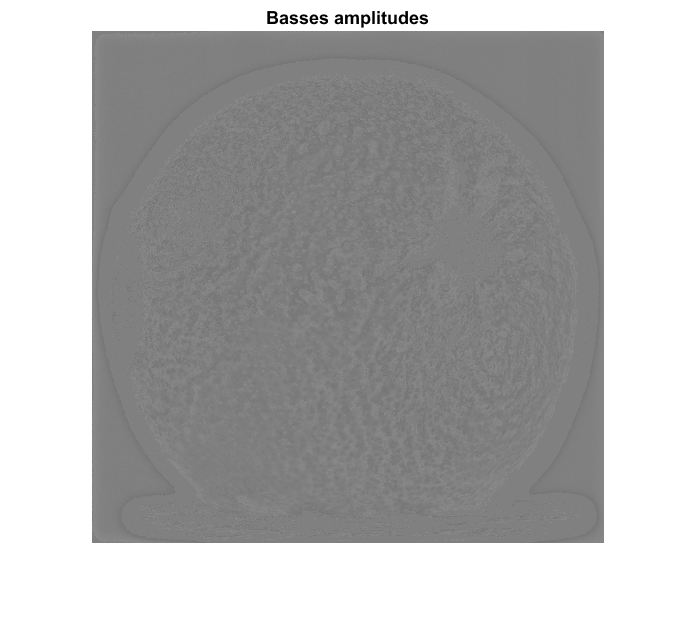

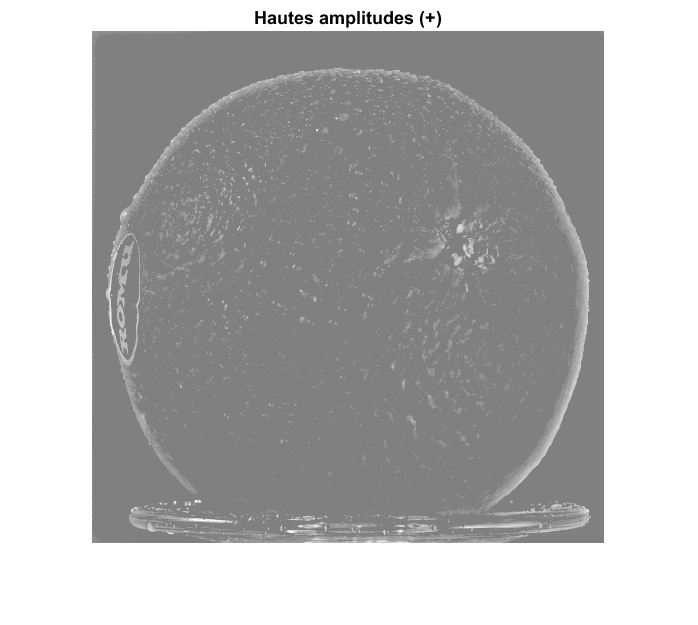

La publication n'est pas précise sur le type de filtre à utiliser. Mais avant de parler de filtre, il est important d'appliquer une manipulation de contraste local sensible aux contours des images. La méthode localcontrast fait se travail efficacement et sans trop poser de questions. Ensuite, il est possible d'appliquer un filtre linéaire passe-bas classique tel qu'un filtre gaussien. Pour obtenir un filtre passe-haut, il suffit de faire 1 - Fpasse-bas. Voici une représentation des filtres utilisés:

Fpasse-bas size = 50 sigma = 7 |

Fpasse-haut size = 50 sigma = 7 size = 50 sigma = 7 |

|

|

|

|

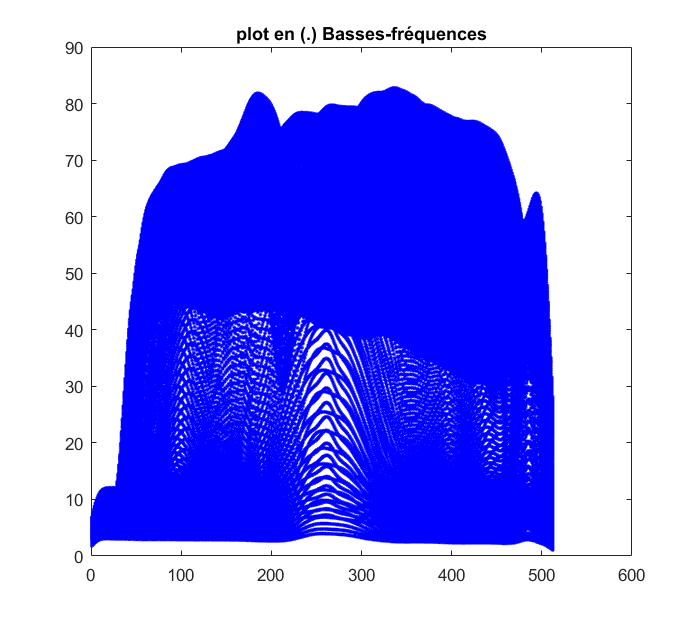

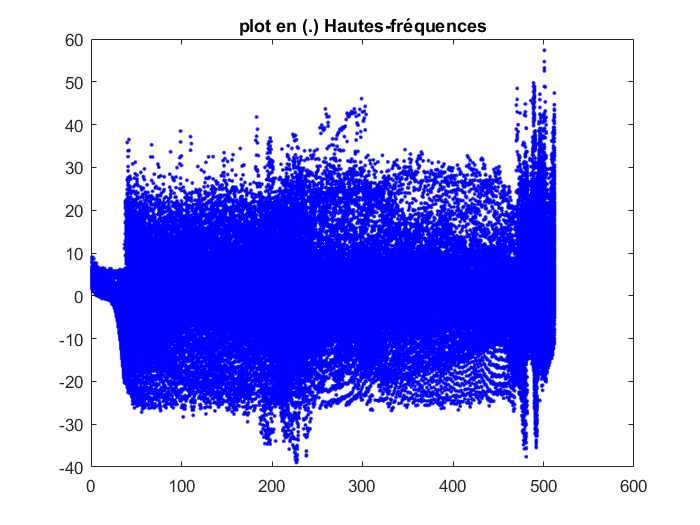

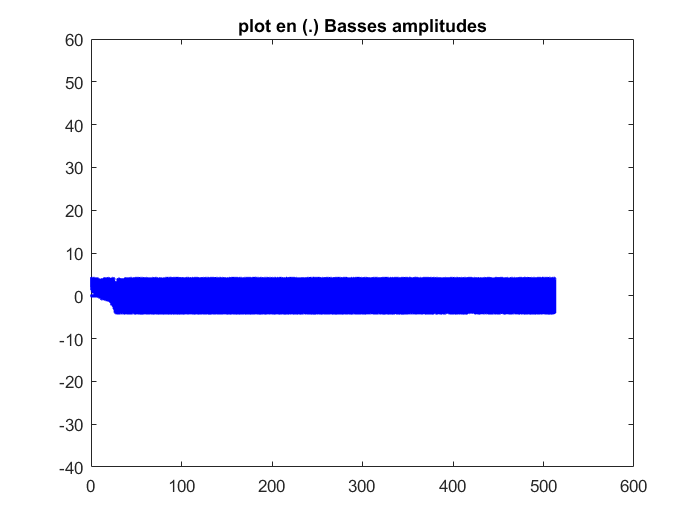

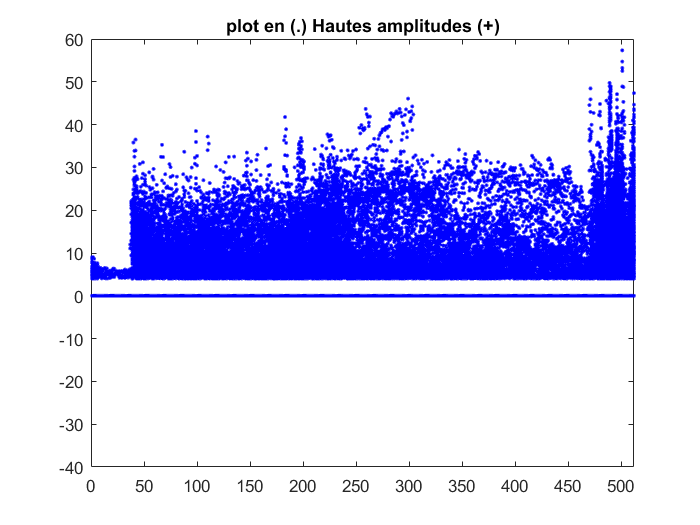

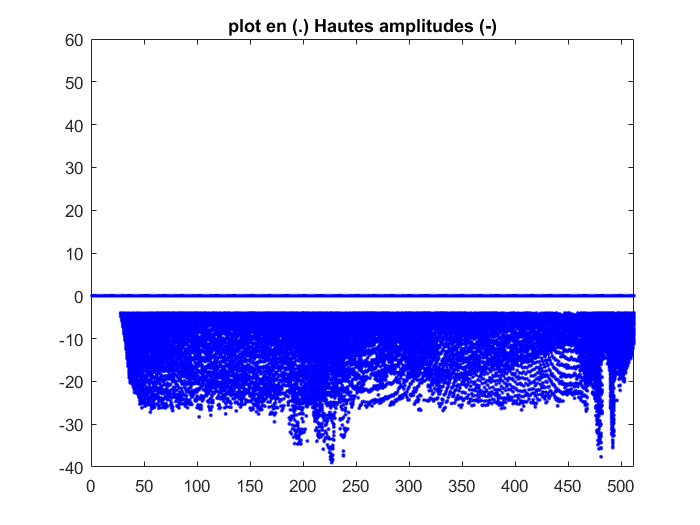

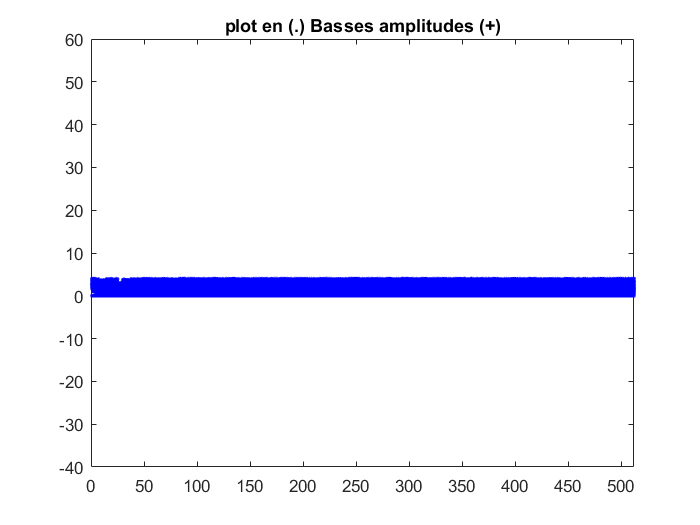

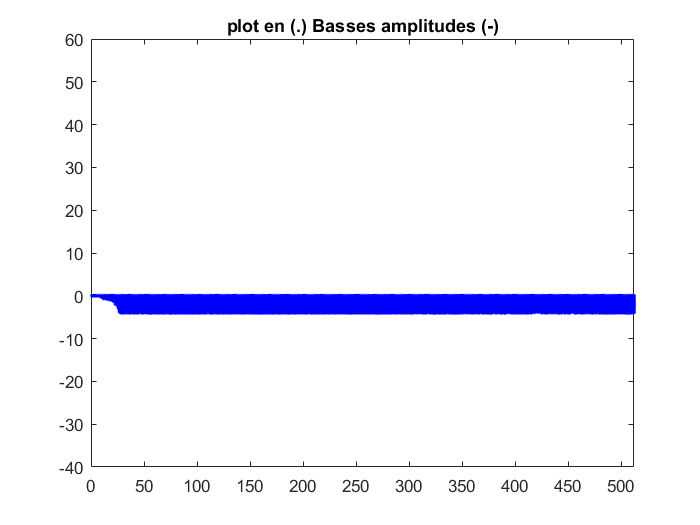

Ce qui peut être intéressant c'est de regarder la distribution des valeurs suite au filtrage. Comme on peut voir dans les figures de plot, la distribution semble segmentée en deux zones pour les basses fréquences. Une zone entre 0 et 10 et une autre entre 40 et 70. Cette séparation n'est absolument pas présente avec les hautes fréquences. C'est tout à fait normal, le filtre passe-haut est un filtre qui élimine les valeurs "DC". Donc, il normalise les valeurs à zéro. Nous allons alors jouer avec ces valeurs.

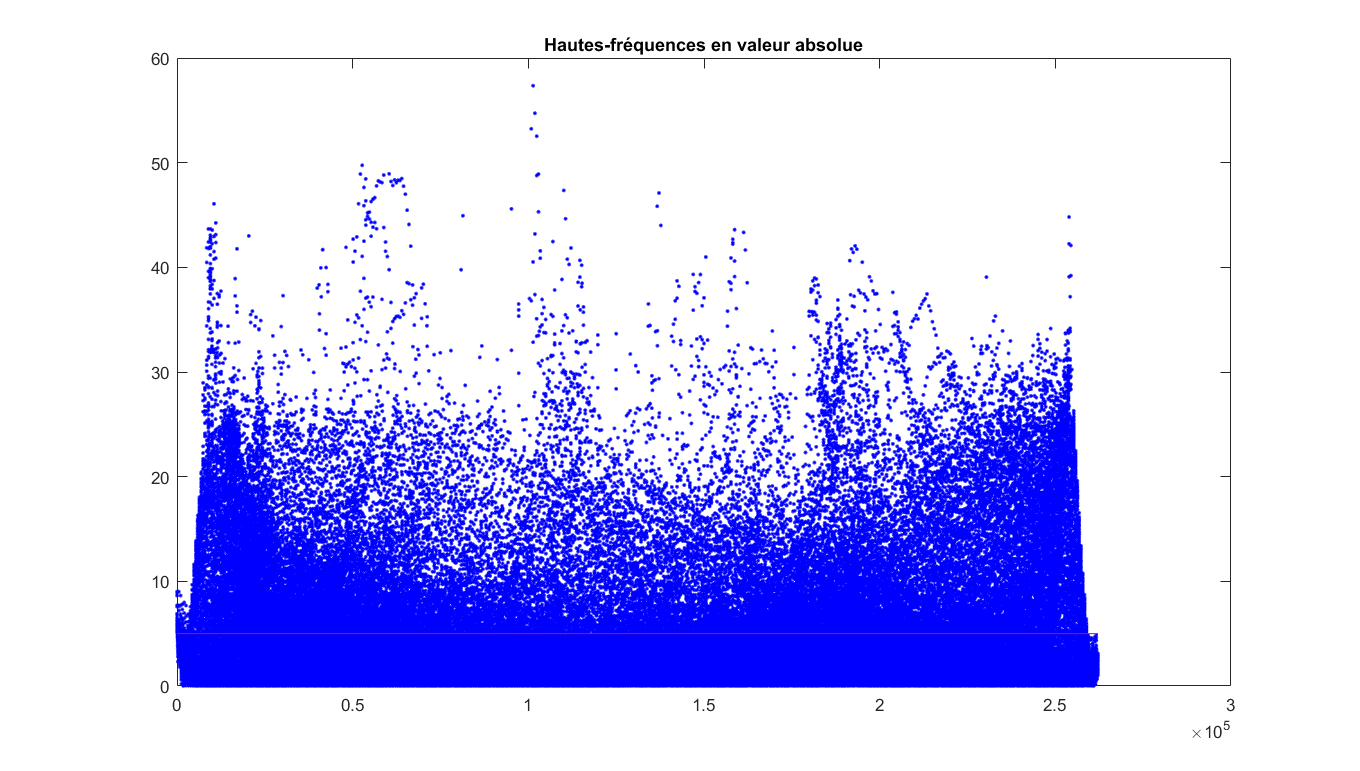

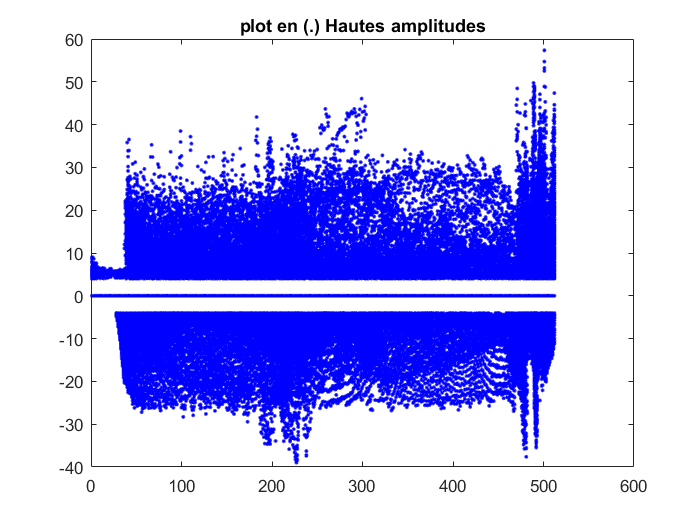

Tamisage en amplitude

Le tamisage en amplitude est une méthode empirique de filtrage sur la distribution des amplitudes de chaque pixel en valeur absolue. Le paramètre sera δ pour le threashold. Comme mentionné plus haut, les valeurs ne sont pas distribuées de façon uniforme et il est possible de tamiser ces deux groupes pour ajuster le bruit de l'image. En termes de programmation, il s'agit de garder ou non un pixel s'il est plus grand que telle amplitude en valeur absolue. La valeur d'un pixel qui n'est pas conservée est zéro. Note: Cette étape est réalisée seulement sur les hautes fréquences.

mean(mean(abs( varHF ))) = 3.5581Valeur utilisée δ = 4 |

|

|

|

|

|

Après cette étape, trois images ont été créées à partir de l'image d'origine.

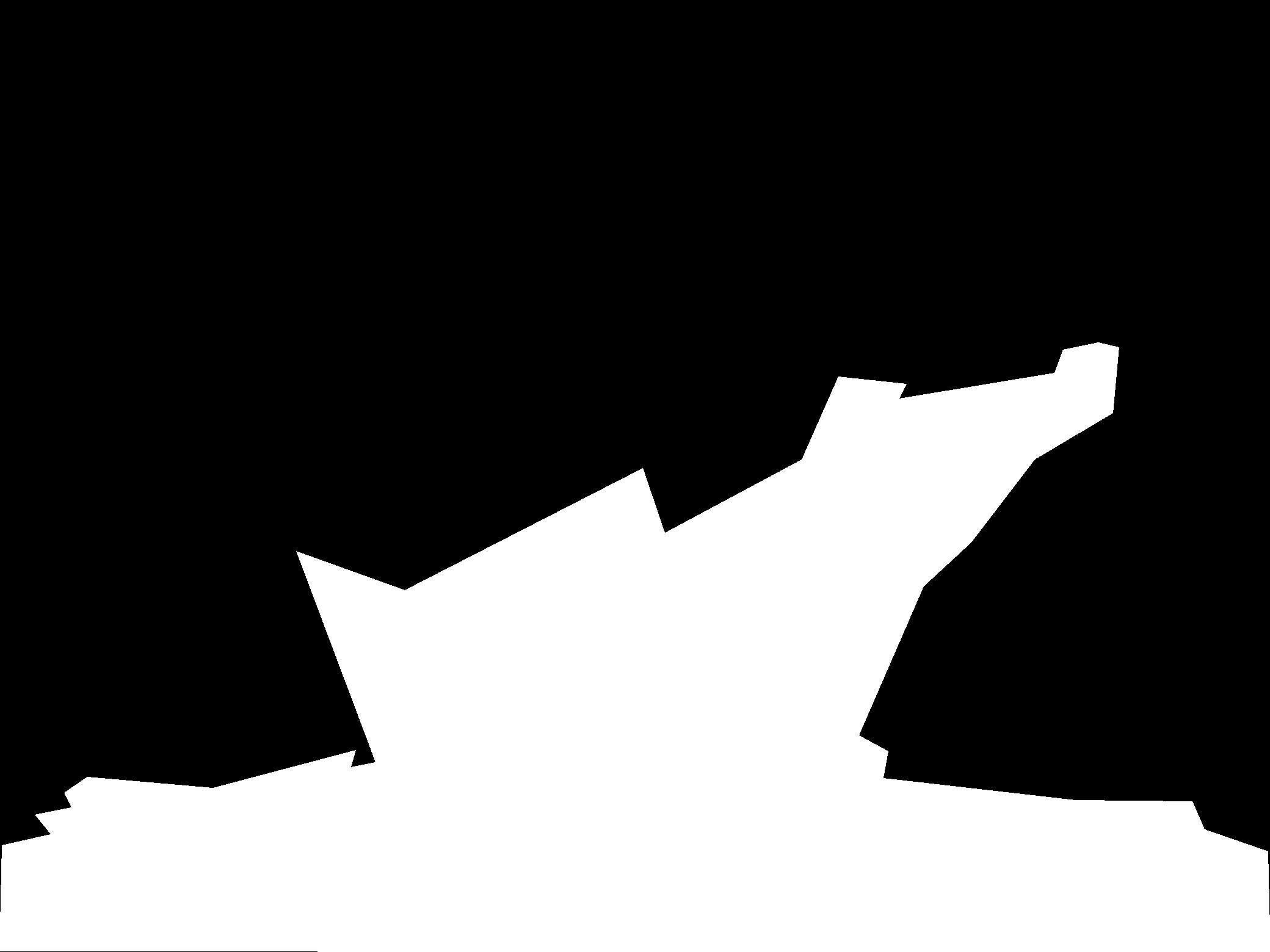

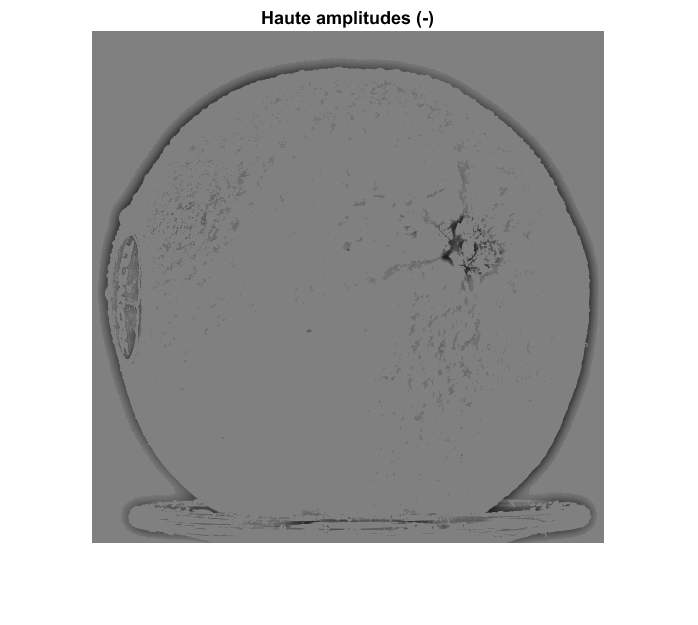

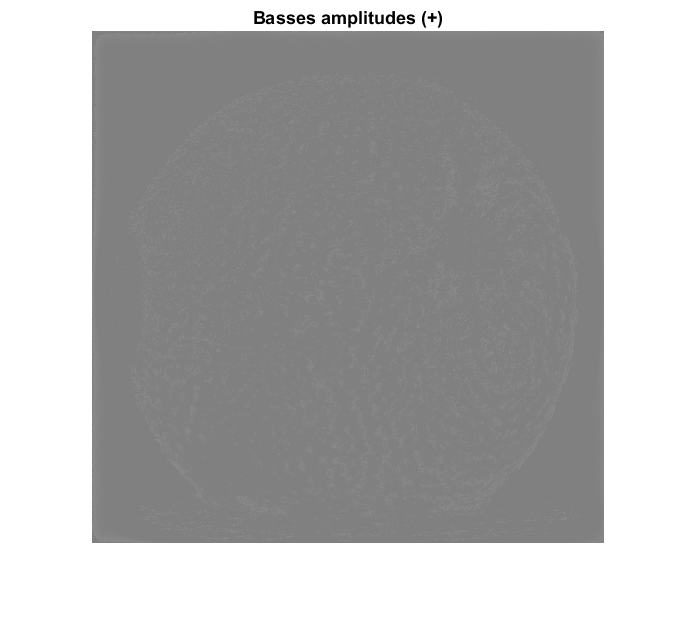

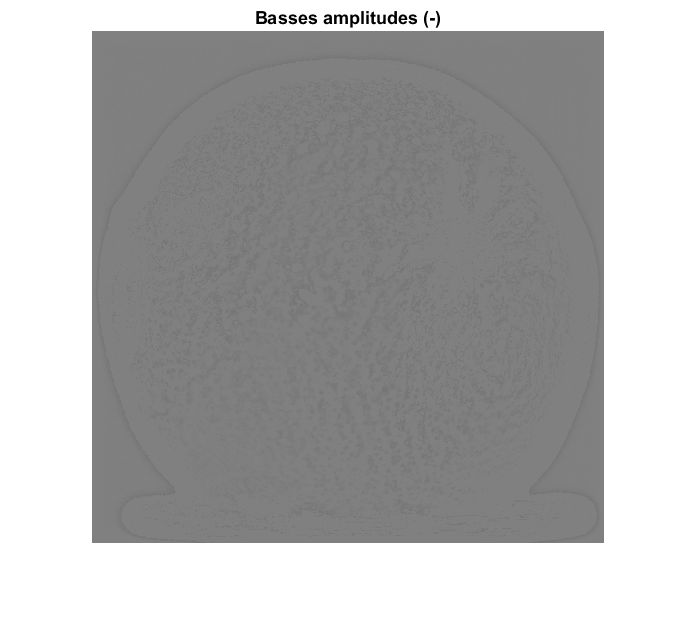

Tamisage en signe

Exactement comme le tamisage en amplitude, ici, l'idée c'est de tamiser la décomposition entre les valeurs positives et les valeurs négatives. La procédure est appliquée sur les images de hautes et de basses amplitudes.

|

|

|

|

|

|

|

|

Cette dernière étape donne alors 5 images qui peuvent être utilisées comme outils de modification d'une image.

Représentation des différentes possibilités de tamisage.